L’opérateur historique, ce n’est pas que les logiciels de sécurisation un peu douteux ou un service marketing vivant sur une autre planète. Orange est aussi (et surtout) un groupe mondial dont les projets de recherche et développement sont ultra pointus. Il faut bien faire la différence entre les produits marketing grand public que l’entreprise commercialise et les produits, plus confidentiels, qu’elle aimerait vendre par exemple à d’autres opérateurs. Avant de rentrer dans le coeur du sujet, je tiens à préciser que je n’accuse aucunement l’opérateur de vouloir directement attenter à votre vie privée « à vous » … mais peut être que les marchés chinois ou iraniens… Par contre, je l’accuse clairement (comme d’autres opérateurs .. SFR pour pas les nommer) d’un douteux mélange des genres qui conduit de fait à des atteintes à la neutralité des réseaux. Notez également que je ne parle ici que des travaux de recherche d’Orange, d’AT&T et d’autres sur lesquels je suis tombé avec fo0 (ça devient une tradition) et que l’on trouve aisément en tapant quelques requêtes bien senties dans notre moteur de recherche de préféré.

L’opérateur historique, ce n’est pas que les logiciels de sécurisation un peu douteux ou un service marketing vivant sur une autre planète. Orange est aussi (et surtout) un groupe mondial dont les projets de recherche et développement sont ultra pointus. Il faut bien faire la différence entre les produits marketing grand public que l’entreprise commercialise et les produits, plus confidentiels, qu’elle aimerait vendre par exemple à d’autres opérateurs. Avant de rentrer dans le coeur du sujet, je tiens à préciser que je n’accuse aucunement l’opérateur de vouloir directement attenter à votre vie privée « à vous » … mais peut être que les marchés chinois ou iraniens… Par contre, je l’accuse clairement (comme d’autres opérateurs .. SFR pour pas les nommer) d’un douteux mélange des genres qui conduit de fait à des atteintes à la neutralité des réseaux. Notez également que je ne parle ici que des travaux de recherche d’Orange, d’AT&T et d’autres sur lesquels je suis tombé avec fo0 (ça devient une tradition) et que l’on trouve aisément en tapant quelques requêtes bien senties dans notre moteur de recherche de préféré.

Enfin, sachez que ce billet est forcément partial et cette partialité est motivée par le fait que je pense avoir de sérieuses raisons d’appréhender un détournement technologique dicté par des lobbies, des politiques et des sociétés dont c’est tout simplement l’intérêt économique. Si vous cherchez un avis neutre, ce n’est pas le bon blog… je me revendique comme étant « quasi pas neutre du tout », ce billet sera donc aussi « quasi (pas) neutre » que les conclusions du Colloque Net Neutrality de l’ARCEP par Nathalie Kosciusko Morizet.

La Deep Packet Inspection au service de la maîtrise et du bon fonctionnement des réseaux

La Deep Packet Inspection (ou analyse de paquets en profondeur) a assez mauvaise presse. Elle touche à des notions qui font assez peur et l’opérateur historique lui même, en arrive, dans certains de ses documents, à la conclusion que la concilier avec le respect de la vie privée est quasiment impossible… et pour cause, à partir du moment où vous identifiez le contenu d’une communication pour privilégier tel ou tel flux, tel ou tel protocole, donc telle ou telle information, on peut affirmer que vous violez le contenu d’une correspondance privée au sens du code des postes et des télécommunications. Ce que je viens de vous exposer, c’est le point de vue d’une personne qui s’inquiète un peu de l’Orwellisation de notre société de l’information. On va tempérer un peu notre propos avec le point de vue d’un fournisseur d’accès et vous allez tout de suite comprendre que la DPI n’est pas, totalement, incompatible avec la notion de neutralité du Net. La condition numéro 1 pour avoir un réseau neutre, c’est que le réseau fonctionne (oui je sais ça a l’air un peu bébête comme ça mais je vous assure que ça aide). On ne va pas se voiler la face, sur un réseau des menaces existent : des malwares, des flux de connexions non conventionnels, des worms …autant de joyeusetés qui se baladent de tuyaux en tuyaux occasionnant dans le meilleur des cas des congestions, dans le pire des cas, des coupures ou des dysfonctionnements. Pour que nos réseaux fonctionnent correctement, il faut donc les protéger de certains flux, c’est l’un des « bons » usages de la DPI, on l’assimilera à des techniques destinées à maintenir une qualité de service (ou QoS).

Mais, d’expérience …

L’histoire nous montre que quand on met une arme de chasse entre les mains des hommes, ces derniers ne peuvent se s’empêcher de la retourner contre leurs semblables.Si l’on considère donc maintenant que la DPI est une arme, on sait qu’elle se retournera contre ceux qu’elle est sensée servir. De curieuses mutations génétiques de la DPI vont donc voir le jour. Premier exemple avec la stochastic packet inspection. Je suis navré d’employer des mots un peu compliqués, mais je vais faire mon possible pour que la suite soit intelligible de tous, d’avance je vous prierais de m’en excuser, mais comme on parle ici de thèmes de recherches, il faut comprendre qu’il s’agit de technologies non maitrisées (en tout cas par moi) et donc complexes à aborder. Aussi, si vous êtes chercheur et que vous maîtrisez les techniques évoquées ici, j’espère que vous me pardonnerez mon manque de connaissances sur ces sujets et je serais ravis d’échanger avec vous pour parfaire (m)la bonne compréhension des informations ici communiquées.

DPI et innovation dans les réseaux de télécommunication

Dans les réseaux Télécom, l’innovation a plusieurs fonctions, les plus nobles sont celles qui servent les intérêts des utilisateurs :

- De nouveaux services

- Une qualité de service qui augmente les performances des usages communs des utilisateurs

- Plus de sécurité pour les données personnelles

Puis il y a les innovations qui servent (et je ne dis pas pour le moment que c’est un mal) les intérêts financiers d’un fonds pensions américain (oui, là c’est bien de Numericable que je parle) ou d’actionnaires en général :

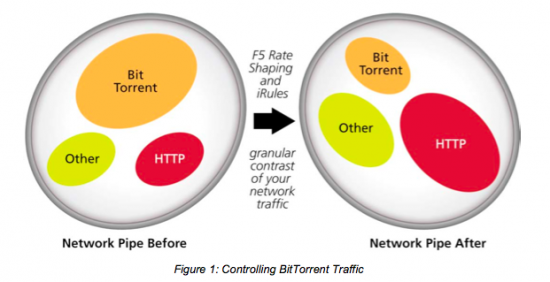

- Optimisation des ressources (c’est la formule de politesse pour désigner le bridage ou le traffic shaping)

- Profilage des abonnés en vue de vente de bases de données pour une exploitation à des fins publicitaires

- Plus de sécurité pour son réseau (ça passe aussi par la sécurisation des abonnés mais ça, côté opérateur, c’est business qu’on vend usuellement quelques euros par mois… et par politesse, je vais éviter de vous dire ce que je pense de ces méthodes et de ces « produits »)

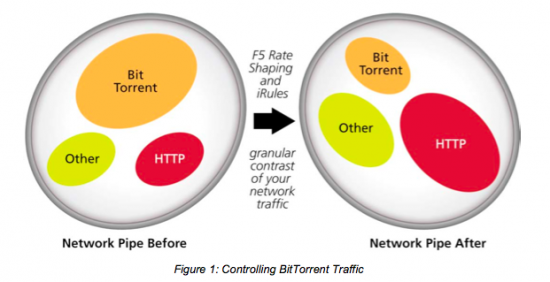

Malheureusement, ces intérêts ne convergent pas toujours. Ainsi la qualité de service pour un internaute c’est quand il « downloade à bloc sur Bit Torrent » et pour un fournisseur d’accès, c’est quand il se tape pas une douloureuse de bande passante trop importante en trafic transatlantique (c’est d’ailleurs pour ça qu’Orange, il y a quelques années déployait des stratégies de cache sur les réseaux peer to peer en Hollande si ma mémoire est bonne).

- Nouveau service : abonné content —> plus d’abonnés = intérêt convergent (pour ça le spécialiste en France, c’est Free)

- Optimisation des ressources : économies pour le fournisseur de service qui est content —> Le service marche moins bien pour l’abonné donc il est pas content = intérêt divergent

- plus de sécurité pour le réseau de l’opérateur : restriction sur un protocole —> l’abonné a moins d’Internet —> abonné pas content —> l’opérateur a un truc en moins a surveiller, les paquets son bloqués = intérêt divergent

Initialement, sur le papier, la DPI est une technologie présentée comme pouvant réduire la fracture entre l’abonné et le fournisseurs de services quand leurs intérêts divergent. Dans le meilleur des mondes, le fournisseur d’accès utiliserait ces outils pour que les fournisseurs de services et de contenus puissent proposer aux internautes ce qu’ils ont à leur proposer, dans les meilleures conditions possibles et… sans discrimination. Ces services et contenus seraient évidemment ceux que les internautes recherchent (en terme de volume trafic, ça nous donne au pif 40% de P2P/newsgroups binaries, DCC, megaupload, 20% de p0rn, 30% de youtube/dailymotion et 10% pour le reste). Si le fournisseur d’accès à Internet n’était QUE fournisseur d’accès, il optimiserait son réseau pour répondre à ces usages.

Tout ceci fonctionnerait super bien si les fournisseurs d’accès faisaient vraiment leur métier. Le soucis, c’est que chez nous, les fournisseurs d’accès sont aussi fournisseurs de services, éditeurs de contenus, et bientôt douane volante… ce qui fait beaucoup de casquettes pour que ces derniers aient un intérêt quelconque à conserver un Net neutre et répondant vraiment à la demande des internautes

Un réseau sur lequel les ressources rares sont correctement gérées est un réseau qui fonctionne mieux, un réseau qui est moins vulnérable à des sources de dysfonctionnement dus à des usages abusifs qui peuvent mettre tout le réseau en danger, est un réseau sur lequel abonnés et fournisseurs d’accès (à ne pas confondre avec fournisseurs de services) sont contents. Mais voilà que le récent colloque de l’ARCEP détermine on ne sait trop par quel cheminement intellectuel que la neutralité du Net, c’est la liberté « d’accéder sans discrimination à n’importe quel contenu LEGAL». Je vous disais de que le fournisseur d’accès Internet allait bientôt porter la casquette de douanier … nous voilà en plein dedans.

Pour déterminer si un octet

- Est légal ;

- Ne viole pas une close contractuelle de l’opérateur ;

- Ne vas pas porter atteinte à la sécurité des autres abonnés.

… le fournisseur d’accès qui transporte l’information dans ses tuyaux (et on ne lui demande surtout pas d’en faire plus) doit analyser l’octet en question, et selon des règles qu’il déterminera lui même (ou que le législateur déterminera pour lui), il violera de fait la correspondance de ses abonnés en analysant le contenus des paquets et en décidant ou non d’acheminer la communication. Il pourra le faire de manière non nominative (c’est surement ce qu’il fera… quoi que) ou nominative (désolé mais j’ai de moins en moins confiance en la CNIL depuis la nomination du sénateur Turk à sa tête).

Confier le rôle de douanier à un fournisseur d’accès (en France, ce sont des sociétés de droit privé) qui est aussi fournisseur de services, fournisseur de contenu et attendre de lui une neutralité est complètement crétin et dangereux.

Surveillance des flux, QoS et bridage du Net

L’intérêt d’Orange (comme de tous les autres FAI qui sont fournisseurs de services et de contenus) pour la Deep Packet Inspection est un fait établit (vu les compétences internes d’Orange en la matière, on se demande même pourquoi il sous-traite ça à des entreprises américaines soumises au Patriot Act, mais c’est un autre débat), on trouve beaucoup de documents du Orange Lab sur ces thématiques. Je vous propose de commencer par cette courte mais intéressante introduction de Didier Duriez avant de lire attentivement ce document qui indique qu’en 2007 déjà, la DPI était au coeur des préoccupations du fournisseur d’accès.

L’analyse de trafic sur un réseau, c’est certes indispensable, en revanche est il tolérable qu’elle serve, sur un réseau sensé être neutre, à traquer des utilisateurs pour lutter contre leurs usages ? Ces usages, ce sont par exemple le Peer to Peer (HADOPI et les dispositifs proposés jusque là ne font aucune différence entre les contenus légaux ou pas, ils se bornent à bêtement interdire le P2P), ou l’utilisation de Skype ou de la voip en général sur les réseaux 3G (…). Et là, croyez moi, on tombe sur des perles, comme ce papier qui a l’air fort intéressant sur la détection de l’utilisation de Skype sur un réseau 3G. Je vais être un peu grossier, mais qu’est-ce que ça peut foutre à un opérateur qui me vend de « l‘Internet mobile illimité » que j’utilise Skype ? … sauf si ce qu’il me vend pour de l’Internet illimité, n’est en fait, comme il l’explique souvent dans ses CGV, qu’un Internet très limité, et dans le volume de données qu’il me permet d’échanger, et dans les services auxquels il me permet d’accéder. Si le fournisseur d’accès ne me vendait pas de minutes de communication à prix d’or, j’aurais tout à fait le droit d’utiliser de la VOIP over 3G sans que ceci le gène … manque chance pour moi, mon fournisseur d’accès à ce pseudo Internet illimité est aussi fournisseur de services téléphoniques et a tout intérêt à brider les services voix pour me les facturer avec sa casquette de fournisseurs de service de téléphonie mobile. Son discours plutôt idiot qui est de dire qu’il interdit la VOIP parce que ça lui coute en ressources sur son réseau alors qu’il vend des abonnements TF1 video pour regarder en direct les matchs de la coupe du monde ou Roland Garros en direct … et donc revêtir sa casquette de fournisseur de contenus « en exclusivité »…ça me donne envie de distribuer des baffes et d’expliquer à tout le monde à quel point ces gens prennent leurs abonnés pour des cons. Du coup, quand je lis ça : « This paper introduces a new method to detect and track Skype traffic and users by exploiting cross layer information available within 3G mobile cellular networks.»… et bien ça réveille en moi un profond sentiment d’agacement et d’inquiétude. Du coup je me pose quelques questions :

- Est ce que mon opérateur téléphonique procède déjà à l’analyse de mes usages en disséquant les paquets de mes communications voix, SMS et data ?

- Si non, projette t-il de le faire ?

- Si oui, pourquoi le fait-il ?

- En a t-il le droit ? (n’est-ce pas le travail des douanes ce genre de perquisition sans commission rogatoire ?)

- Quelles données personnelles collecte t-il ?

- Ais-je le droit d’y accéder ?

- Comment faire pour y accéder ?

Pourquoi je vous parlais d’Orange au fait ?

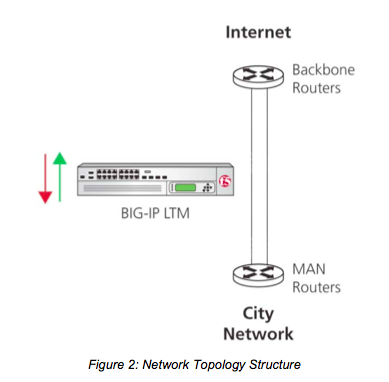

Le Deep Packet Inspection, ça commence quand même à dater. Pour rester dans le coup, quand on a une clientèle vieillissante et que l’image ne prête pas spécialement à la reconquête d’un jeune public, il reste l’innovation. L’un des axes d’innovation d’Orange aujourd’hui, ce sont les grosses appliances réseau, à l’échelle de l’importance du fournisseur d’accès. Orange est un groupe mondial qui ne se contente pas du marché français, et c’est tant mieux… ce sont donc de très grosses appliances… Déjà là, on sent qu’on est assez loin de la PPI (Pifometric Packet Inspection) de TMG qui a semble t-il commencé à collecter les adresses IP sur les réseaux P2P. Très vite on se rend compte qu’Orange a des compétences réelles et sérieuses sur le sujet. Mais ces compétences ne s’arrêtent évidemment pas aux benchmarks du Orange Lab, on se doute bien qu’il y a des « expériences » qui sont déjà en production dans nos DSLAM, et ça, les abonnés non dégroupés de Free en savent quelque chose (le filtrage applicatif, sur la couche 7 du modèle OSI) on sait que c’est en production depuis au moins 2005. Et il y a du nouveau …

Stochastic Packet inspection

« Mais qu’est-ce que c’est encore que cet oiseau là… ? »

Le calcul stochastique est une approche de calcul probabiliste datant des années 50. Ses applications aux réseaux sont elles, très contemporaines. On déduira des diverses choses trouvées sur le Net que la SPI est donc une approche probabiliste d’inspection de paquets visant à en déterminer sa nature et à appliquer des règles en fonction de l’observation de ce qui transite sur le réseau. Tout ceci est fort louable, aucun doute, çapeut rendre de grands services en terme d’optimisation et d’économie de ressources de traitement par exemple.

« C’est grave pour ma Net Neutrality docteur ? »

Je me suis toujours refusé d’avoir peur d’une technologie, en revanche, j’avoue craindre ce que les gens en font (systématiquement dicté par l’apat du gain au détriment de l’intérêt commun). Du coup, je vais vous la faire super courte, en simplifiant à l’extrème avec, je le concède; un point de vue assez partisan : La Stochastic Packet inspection est un quasi proof of concept d’atteinte à la neutralité du Net d’un nouveau genre.

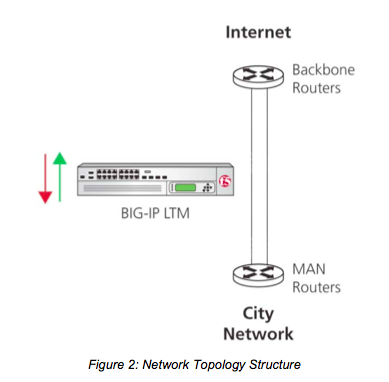

La stochastic packet inspection propose par exemple de se concentrer sur le trafic UDP, le protocole UDP est le protocole de prédilection pour les échanges en peer to peer (en clair, quand vous downloadez comme un puerco sur la Mule, vous faites de l’UDP….). Du coup, chez AT&T on s’active aussi pas mal sur le contrôle des flux P2P. Comprenez qu’il s’agit d’un marché déjà colossal qui pourrait même décupler si des mesures relatives à ACTA venaient à être appliquées un jour ou l’autre… au niveau mondial.

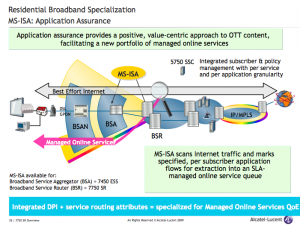

Évidemment chez Orange Lab, on est pas non plus en reste sur les divers moyens de filtrer le P2P (ou d’offrir de nouveaux services). Marcin Pietrzyk et Jean-Laurent Costeux Orange Labs ont même signé un papier très instructif sur le sujet dont l’abstract peut faire peur à la première lecture : privilégier un flux ou carrément « bannir le P2P », heureusement les conclusions sur les approches statistiques de classification de trafic ne proposent pour le moment pas de modèle fiable (mais pour combien de temps ?) :

Accurate identification of network traffic according to ap- plication type is a key issue for most companies, including ISPs. For example, some companies might want to ban p2p traffic from their network while some ISPs might want to offer additional services based on the application. To classify applications on the fly, most companies rely on deep packet inspection (DPI) solutions. While DPI tools can be accurate, they require constant updates of their signatures database. Recently, several statistical traffic classification methods have been proposed. In this paper, we investigate the use of these methods for an ADSL provider managing many Points of Presence (PoPs). We demonstrate that sta- tistical methods can offer performance similar to the ones of DPI tools when the classifier is trained for a specific site. It can also complement existing DPI techniques to mine traf-fic that the DPI solution failed to identify. However, we also demonstrate that, even if a statistical classifier is very accurate on one site, the resulting model cannot be applied directly to other locations. We show that this problem stems from the statistical classifier learning site specific information.

Une autre utilisation de la SPI, beaucoup plus louable celle là est la détection et l’auto-immunisation contre les attaques par dénis de service (Dos) comme le démontre ce papier de chercheurs coréens et datant déjà de 2005. Mais la préoccupation actuelle et donc le nouveau champs d’application, c’est bien le contrôle et le blocage de certaines applications « indésirables » en fonction des services que l’opérateur compte vendre à ses abonnés.

La chasse aux pirates ne profite donc pas qu’aux majors ?

Et non ! Benjamin Bayart l’explique avec le talent qu’on lui connait. Le marché de la surveillance est assez juteux pour que plein d’autres personnes en croquent une part de gâteau, à commencer par les équipementiers (Cisco, Alcatel/Lucent, ..), les fondeurs ou les designers de chip (comme le français Kalray, une émanation du CEA et de STMicroelectronics, ou comme l’américain Reservoir …). Les axes de recherche sur les technologie de surveillance (et celles que je viens de citer ne servent pas qu’à ça, bien heureusement) ont donc des perspectives industrielles très prometteuses…. et là encore, en France on est pas les plus mauvais. Toutefois, les méthodes probabilistes d’inspection de paquets semblent représenter un nouvel eldorado. La multiplication des sondes et des points de présence sur le réseau permettent un taux très intéressant d’efficacité. Si la SPI n’est pas encore 100% opérationnelle, dans un futur proche, conjuguée à la DPI, les technologies de filtrages mises entre les mains des fournisseurs d’accès (qui nous l’avons vu sont aussi fournisseurs de contenus et de services) seront redoutables. Comment ne pas entrevoir des entorses à la neutralité des réseaux, et comment de pas y entrevoir des atteintes à la vie privée des internautes ?

Ressources complémentaires